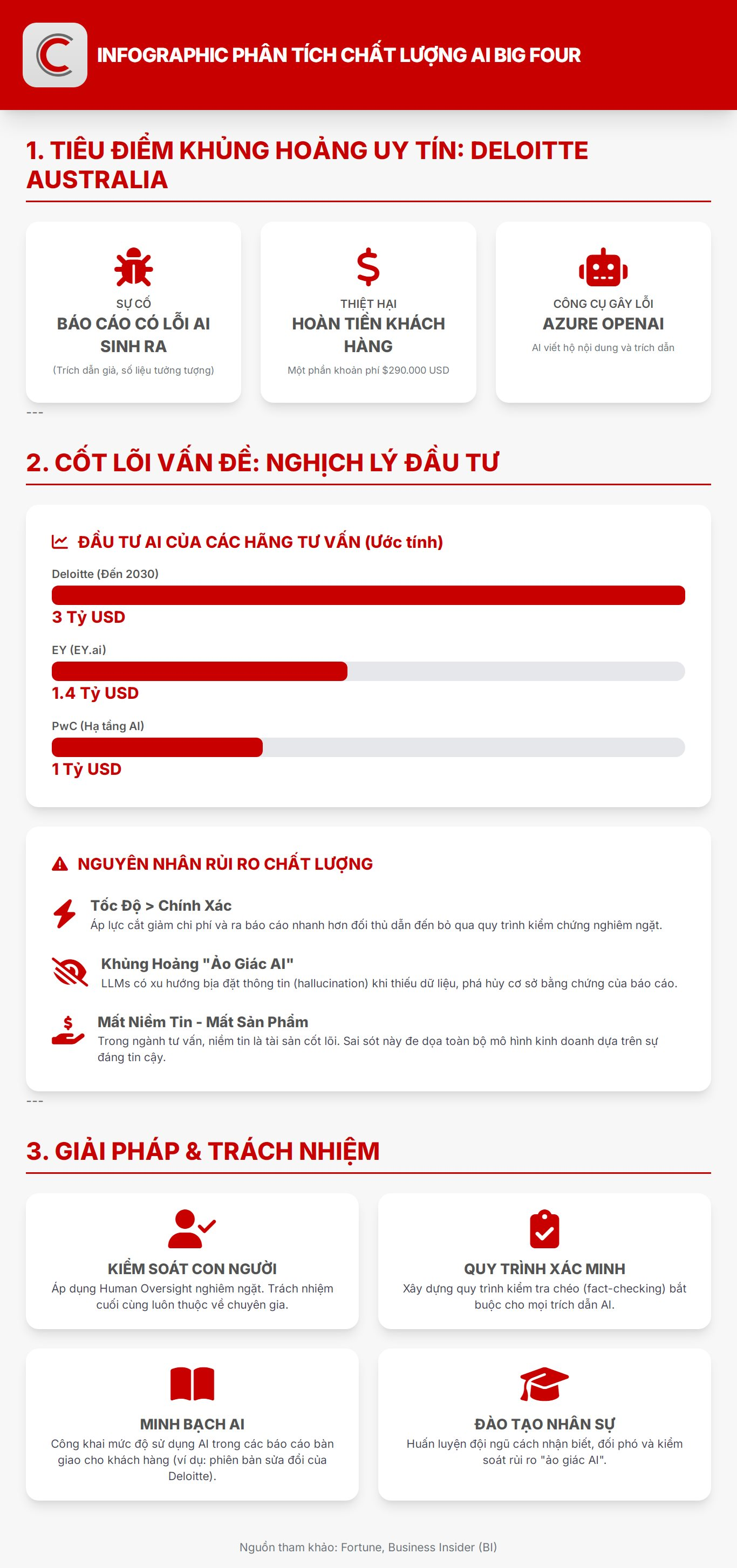

Tờ Fortune cho hay vụ việc Deloitte Australia phải hoàn trả một phần khoản phí 290.000 USD cho chính phủ Australia vì một báo cáo chứa lỗi do trí tuệ nhân tạo (AI) sinh ra đang gây chấn động trong giới tư vấn toàn cầu.

Đằng sau câu chuyện tưởng như chỉ là “sai sót kỹ thuật” ấy là một nghịch lý lớn hơn: các hãng tư vấn hàng đầu thế giới đang chi hàng tỷ USD cho AI để nâng cao hiệu quả, nhưng lại chưa thể kiểm soát được chính công cụ mà họ tôn sùng.

Trong một thị trường kiểm toán mà niềm tin và sự thật là yếu tố cốt lõi để khách hàng ký hợp đồng thì việc bỏ mặc cho AI “viết hộ” đang tạo nên một cuộc khủng hoảng đạo đức toàn diện, đe dọa đến mô hình kinh doanh của các ông lớn Big Four.

Viết hộ

Báo cáo dài 237 trang mà Deloitte thực hiện cho Bộ Việc làm và Quan hệ Lao động Australia (DEWR) công bố hồi tháng 7/2025 được cho là có sử dụng công cụ Azure OpenAI trong khâu soạn thảo. Tuy nhiên phải mãi đến tháng 9/2025 khi nhà nghiên cứu Chris Rudge (Đại học Sydney) đọc kỹ tài liệu, ông mới phát hiện hàng loạt trích dẫn sai, lời dẫn bịa đặt từ một phán quyết tòa án liên bang và những tài liệu học thuật không hề tồn tại.

“Chỉ cần đọc qua là tôi biết đây là sản phẩm của AI, hoặc là thế giới vừa xuất hiện một cuốn sách mà chưa ai từng nghe đến”, Rudge kể lại.

Phản ứng nhanh chóng của truyền thông buộc Deloitte phải kiểm tra lại toàn bộ nội dung, xác nhận có “một số chú thích và tham chiếu không chính xác”, và âm thầm đăng lại bản sửa đổi. Phiên bản mới đã thừa nhận việc sử dụng công cụ AI, đồng thời loại bỏ các trích dẫn giả.

Tuy nhiên, Deloitte vẫn khẳng định “các cập nhật không ảnh hưởng đến nội dung và kết luận của báo cáo”. Dẫu vậy, uy tín của hãng đã bị giáng một đòn mạnh.

Các thượng nghị sĩ Australia như Barbara Pocock của Đảng Xanh, chỉ trích Deloitte đã “lạm dụng AI một cách mà sinh viên năm nhất cũng không được phép làm”.

Vụ việc xảy ra trong bối cảnh các “ông lớn” tư vấn như Deloitte, PwC, EY hay McKinsey đang chạy đua đầu tư vào trí tuệ nhân tạo. Hãng Deloitte tuyên bố rót 3 tỷ USD vào AI đến năm 2030, hợp tác cùng Microsoft và Anthropic để triển khai các mô hình ngôn ngữ thế hệ mới.

Tập đoàn PwC thì đầu tư 1 tỷ USD cho hạ tầng AI và dịch vụ kiểm toán tự động. Thương hiệu EY cũng tung ra nền tảng EY.ai trị giá hơn 1,4 tỷ USD, còn McKinsey phát triển QuantumBlack AI để hỗ trợ tư vấn chiến lược.

Những con số này phản ánh tham vọng AI sẽ giúp cắt giảm chi phí, rút ngắn thời gian nghiên cứu và sản xuất báo cáo, đồng thời mở ra lĩnh vực kinh doanh mới, từ kiểm toán thuật toán đến tư vấn AI cho chính phủ.

Tuy nhiên khi AI được sử dụng để sinh nội dung mà không có quy trình kiểm chứng nghiêm ngặt, “hiệu quả” dễ dàng biến thành "ảo giác AI" (AI hallucinations-những trích dẫn, số liệu tưởng tượng).

Mất niềm tin

Vụ Deloitte Australia không đơn giản là một lỗi kỹ thuật. Nó phơi bày lỗ hổng đạo đức nghề nghiệp trong cách các tập đoàn tư vấn đang ứng xử với công nghệ mới. Trong cuộc đua giành lợi thế, họ coi AI là động cơ tăng tốc, nhưng quên rằng công cụ ấy cần phanh an toàn.

Các AI có thể giúp phân tích hàng triệu dữ liệu, song nó không thể chịu trách nhiệm. Và trách nhiệm ấy trong mọi trường hợp vẫn phải thuộc về con người. Nếu các hãng tư vấn không nhanh chóng xây dựng cơ chế kiểm soát, xác minh nguồn trích dẫn và minh bạch về mức độ sử dụng AI, thì sự cố Deloitte hôm nay có thể chỉ là khởi đầu cho hàng loạt khủng hoảng tương tự.

Trong ngành tư vấn, niềm tin chính là sản phẩm. Các chính phủ, tập đoàn đa quốc gia hay ngân hàng trung ương thuê Deloitte, PwC hay McKinsey không chỉ vì dữ liệu, mà vì tin rằng họ kiểm soát được sự thật.

Một khi niềm tin đó lung lay, không chỉ uy tín của một báo cáo bị ảnh hưởng mà là toàn bộ mô hình kinh doanh dựa trên danh tiếng “đáng tin cậy tuyệt đối”.

Deloitte có thể nói rằng các lỗi trong báo cáo không thay đổi kết luận, nhưng về mặt biểu tượng, thiệt hại là khó đo đếm. Khi chính phủ phải hoàn tiền vì “AI ảo giác”, điều đó đặt ra câu hỏi: trong các lĩnh vực như pháp lý, y tế, tài chính, nơi một trích dẫn sai có thể dẫn đến hậu quả lớn, liệu chúng ta đã sẵn sàng để giao quyền viết lách cho máy?

Theo Fortune, các mô hình AI sinh ngôn ngữ hiện nay như GPT-4 hay Claude có khả năng viết trôi chảy, nhưng chúng không có khái niệm “đúng” hay “sai”. Khi được yêu cầu trích dẫn học thuật hoặc tóm tắt án lệ, chúng có thể “bịa” thông tin sao cho hợp ngữ cảnh. Deloitte dường như đã quên rằng AI không phải nhà nghiên cứu, cũng không chịu trách nhiệm pháp lý.

Theo Hội đồng Báo cáo Tài chính Anh (FRC), các Big Four đang “không theo dõi đầy đủ ảnh hưởng của AI và công nghệ tự động lên chất lượng kiểm toán”. Trong khi đó, áp lực cạnh tranh khiến họ triển khai nhanh hơn mức có thể kiểm soát. Càng đầu tư nhiều vào AI, các hãng càng bị cuốn vào cuộc đua “đưa sản phẩm ra thị trường trước đối thủ”, thay vì chậm lại để xây dựng cơ chế kiểm soát rủi ro.

Kết quả là những lỗi cơ bản như trích dẫn sai hoặc gán nhầm lời cho thẩm phán lại xuất hiện trong các tài liệu đáng ra phải đạt độ chính xác học thuật tuyệt đối.

Deloitte từng tự hào là biểu tượng của sự chính xác, nơi mọi con số và lời dẫn đều được kiểm chứng qua nhiều tầng chuyên gia. Thế nhưng khi “bộ não nhân tạo” được phép tham gia vào chu trình đó mà thiếu giám sát, ngay cả một thương hiệu trăm năm cũng có thể vấp ngã.

Trong kỷ nguyên AI, điều các hãng tư vấn cần đầu tư không chỉ là sức mạnh tính toán, mà còn là trách nhiệm và cơ chế kiểm soát con người. Bởi lẽ, trí tuệ nhân tạo có thể viết nhanh hơn, rẻ hơn, nhưng chỉ con người mới biết điều gì là thật và điều gì xứng đáng để tin.

*Nguồn: Fortune, BI

.png)

.png)

.png)